[Français]

Bonjour,

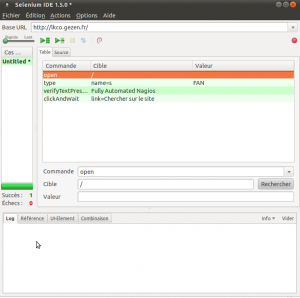

je suis fier de vous annoncer la disponibilité de la nouvelle monture FAN 2.4/

C’est la nouvelle version stable de FAN . L’iso est téléchargeable sur http://www.fullyautomatednagios.org/wordpress/download/

Les nouveautés :

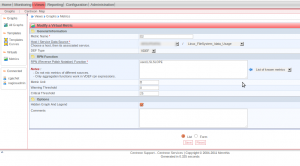

- Nagios 3.4.4

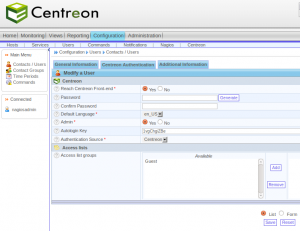

- Centreon 2.4.1

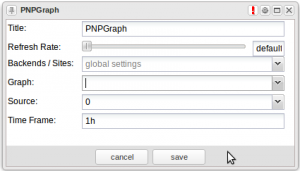

- Nagvis 1.7.6

- Nagios plugins 1.4.16

- CentOS 5.9 system

- Add nagios-plugin-wmi-plus

- Add nagios-plugin-esxi

- Add nagios-plugin-nwc-health

- Add nrdp-plugin

- Full changelog

[English]

I’m very proud to announce the availability of a new version of FAN : 2.4.

This version of FAN is in stable status. You can download FAN 2.4 iso here : http://www.fullyautomatednagios.org/wordpress/download/

Changes :

- Nagios 3.4.4

- Centreon 2.4.1

- Nagvis 1.7.6

- Nagios plugins 1.4.16

- CentOS 5.9 system

- Add nagios-plugin-wmi-plus

- Add nagios-plugin-esxi

- Add nagios-plugin-nwc-health

- Add nrdp-plugin

- Full changelog